„Wikipedia zerstört die Idee der Informationsfreiheit“.

Mit dieser provokanten und widersprüchlich klingenden Aussage hat sich bereits eine ganze Schar von Menschen im Web gegen Wikipedia ausgesprochen. Doch nicht das Wissen selbst oder die Inhalte von Wikipedia stehen im Mittelpunkt der Kritik, sondern seine technische Struktur. Um zu verstehen, inwiefern diese Kritik gerechtfertigt ist, wird ein Rückblick in die Entwicklung des Internets aus einer besonderen Sichtweise notwendig.

Die ursprüngliche Idee von Google Search, Websites untereinander nach Wichtigkeit zu bewerten, geht auf eine alte Idee aus der Wissenschaft zurück: die Namen der Wissenschaftler an Universitäten nach der Menge ihrer Zitationen aufzulisten. Denn wer früher sehr häufig von anderen zitiert wurde, stieg im Ranking der Wissenschaftler. Daraus entstand dann eine Hochschuldatenbank, die sich bei der Nennung ihrer Autoren des gleichen Prinzips bediente. Bekannt ist diese Datenbank noch heute als der „Zitationsindex“.

Die beiden Studenten und Google-Gründer Sergey Brin und Larry Page übertrugen die Idee auf ihre eigene Suchmaschine: Je mehr Nutzer auf eine Website verlinken, desto wichtiger wird sie. Und je wichtiger eine Website wird, desto höher wird sie in den Suchtreffern aufgelistet. Aus dem ursprünglichen Zitationsindex aus der Wissenschaft entstand also der Google PageRank. Schließlich wurde er zum bedeutsamsten Bewertungskriterium innerhalb von Suchmaschinen, bekannt vor allem unter dem Namen „Link Popularity“. Andere Suchmaschinen folgten dem Beispiel und verwenden für die Listung der Websites ebenfalls das Prinzip des Google PageRanks.

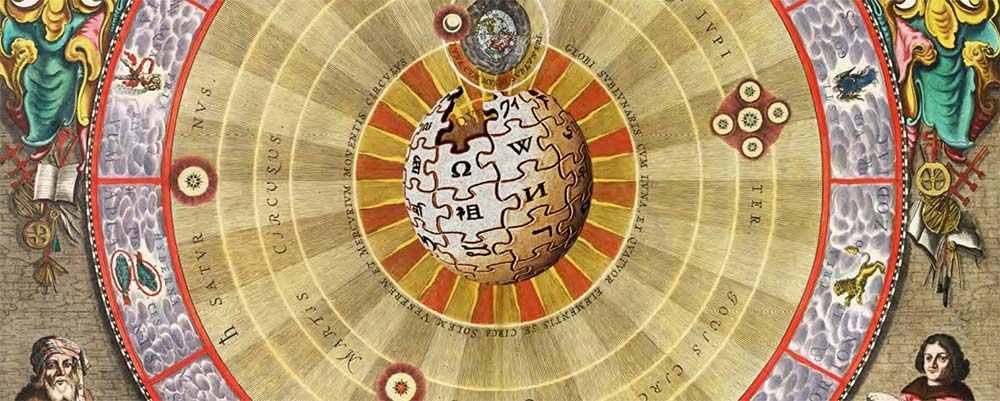

Zurück zum Problemfall Wikipedia: Ebenfalls nicht neu ist die Idee des Webs, URLs untereinander zu verknüpfen, so dass eine Art vernetzte Struktur entsteht. Bedenken wir, dass es vor hunderten von Jahren bereits Wörterbücher gab. Im Jahr 1751 erschien die erste Enzyklopädie. Ursprung des Begriffs ist das griechische Adjektiv „egkyklios“, was kreisförmig bedeutet. Denn letztlich „dreht“ sich das Wissen der Welt durch viele Aspekte hindurch. Ständig widerholt es sich und ist querverknüpft mit alle möglichen Wissenseinheiten auf der Welt. Optimalerweise kehrt man in einer Enzyklopädie wieder an den Ursprungspunkt zurück, wo man angefangen hat zu suchen – der Kreis schließt sich. Das war auch die Absicht der Erfinder der Enzyklopädie Denis Diderot und Jean le Rond d’Alembert. Ihnen ging es vor allem darum, durch „Querverbindungen“, wie sie es selbst nannten, Wissen zu erfassen und „gegenseitige Verflechtungen sichtbar zu machen“ (Diderot & le Rond d’Alembert, 1751).

Nicht ohne Grund nannte Tim Berners Lee seine Erfindung im Jahre 1994 das „World-Wide Web“. Seine Idee war, durch das Web der Öffentlichkeit Wissen mit vielen Verflechtungen und Querverlinkungen verfügbar zu machen. Dabei sollte es sich durch seine Verlinkungsstruktur nach und nach zu einem Spinnennetz formen.

Tim Berners-Lee, der Erfinder des Webs

Auf der einen Seite steht also Google, der die Grundzüge einer selbstregulierenden Gesellschaft in sich trägt. Durch die Querverlinkungen, die letztlich die Nutzer selbst setzen, entsteht quasi eine von der Gemeinschaft selbst bestimmte Relevanz des Wissens – hier findet sich auch der Wunsch nach Selbstregulierung wieder. Die Idee der Enzyklopädie ist es ebenfalls, Wissen querverlinkt verfügbar zu machen. Die Verbindung beider Welten ergibt im Grunde eine für die Gesellschaft wichtige Eigenschaft: Wissen kann abhängig von ihrer Bedeutung von der Gesellschaft selbst bewertet werden. Die Selbstregulierung dient als Informationsfilter. Gesellschaftliches Wissen wird dadurch leichter erreichbar und auffindbarer, Fachinformationen befinden sich einige Stufen tiefer.

Einseitigkeit von Wikipedia

Wikipedia ist keine gewöhnliche Enzyklopädie. Es ist ein Teil des Webs und hat mit 25 Millionen Einträgen nebst Facebook, YouTube u. a. das größte Webangebot der Welt. 0,25 Prozent des gesamten Internetverkehrs bei Suchanfragen wird von Wikipedia bearbeitet. Dennoch sieht sich Wikipedia anscheinend nicht als ein Teil einer gemeinschaftlichen Struktur des Webs. Warum ist das so?

Mit einer technischen Eigenschaft im Quellcode erlaubt es Wikipedia nicht, seine Links durch Suchmaschinen bewerten zu lassen. Alle Verlinkungen, die von Wikipedia hinausgehen, sind technisch so beschaffen, dass keine Suchmaschine sie beachten darf. Selbst wenn Wissenschaftler, Autoren oder Fotografen in Wikipedia in hohem Maße zitiert und verlinkt werden, hat diese Verlinkung keinen Einfluss, weder auf deren Wichtigkeit noch auf deren Websites. Gleiches gilt auch für Links von Unternehmen, Vereinen oder Personen.

Im Quellcode wird jeder Link von Wikipedia mit NOFOLLOW versehen. Das signalisiert Google, dem Link nicht zu vertrauen.

Verantwortlich für diese Eigenschaft ist ein Attribut namens „REL-NO-FOLLOW“. Dieser zunächst etwas kryptisch erscheinende Code ist im Grunde eine Funktion, die jeder Webmaster in seine eigene Website einem bzw. jedem Link zuordnen kann. Wird ein Link mit diesem Attribut versehen, wird der Suchmaschine verboten, dem Link zu folgen bzw. ihn überhaupt wahrzunehmen. Der von der Wissenschaft entwickelte Zitationsindex wird mit Wikipedia also komplett wieder verworfen.

Dabei spielt Wikipedia ein gänzlich einseitiges Spiel: Google bewertet sehr wohl die Inhalte von Wikipedia, immerhin tauchen diese bei den Suchergebnissen von Google stets relativ weit oben auf. Dies liegt natürlich im Interesse von Wikipedia. Schließlich lebt die Enzyklopädie von der Anteilhabe der Gesellschaft insgesamt, sei es aktiv oder passiv.

Wer es bei Wikipedia zu einem Zitat geschafft hat, weil er beispielsweise eine Abhandlung über gesellschaftsrelevante Themen verfasst hat, wird oft in Wikipedia zitiert oder referiert. Üblicherweise werden viele Zitate sowie andere Referenzen bei Wikipedia als Linksammlung am Ende der Artikel aufgeführt. Alle diese Referenzen und Links sind allerdings von Wikipedia automatisch mit einem REL-NOFOLLOW im Code versehen. Das bedeutet, dass der eigentliche Wissensvermittler und Forscher keine Chance hat, bei Suchmaschinen für sein Wissen bewertet zu werden. Sein Eintrag ist, außerhalb von Wikipedia, quasi nichts wert.

Ein Beispiel hierfür ist das Themenportal „Teilchenphy-sik.org“. Der Betreiber der Website, eine gemeinnützige Stiftung, stellt zu diesem Thema eine große Menge an Informationen zur Verfügung. Der Profiteur dieses Wissens ist unter anderem Wikipedia. Die Online-Enzyklopädie veröffentlicht unter anderem das gewonnene Wissen zum passenden Artikel „Teil-chenphysik“ in abgewandelter Form. Als besonderen Dank und als Anerkennung wird von den Wikipedia-Autoren schließlich ein Link auf das Portal „Teilchenphysik.org“ im Wikipedia-Artikel gesetzt. Nun würde man annehmen, dass dadurch das Portal „Teilchen-physik.org“ eine höhere Anerkennung in Suchmaschinen gewinnt. Dem ist nicht so. Der Grund dafür liegt im dem von Wikipedia gesetzten Attribut REL-NOFOLLOW, das sich unmittelbar innerhalb des Links zu „Teilchenphysik.org“ befindet. Es signalisiert der Suchmaschine: „Nicht folgen und nicht beachten“. Dabei ist es selbst Wikipedia-Autoren nicht möglich, den REL-NOFOLLOW abzuschalten, da er zu jedem Link automatisch gesetzt wird.

Gesellschaftskonform wäre es jedoch, wenn die Website „Teilchenphysik.org“ von den Suchmaschinen bewertet werden könnte, sobald sie in Quellen wie Wikipedia auftaucht. Schließlich ist die Struktur des Webs so geschaffen, dass diese Anerkennung nicht nur möglich, sondern auch von allen gewollt ist. Eine solche Belohnung würde auch im Einklang mit den bisherigen gesellschaftlichen Entwicklungen stehen, wie beispielsweise dem erwähnten Zitationsindex oder dem PageRank.

Doch es bleibt dabei. Gibt man „Teilchenphysik“ in Google als Suche ein, wird die Website innerhalb der ersten Treffer nicht mal angezeigt. Schuld ist im Grunde also nicht Google, sondern die technische Beschaffenheit von Wikipedia. In SEO-Sprache würde man sagen: „Der Backlink von Wikipedia führt zu keinem Trust bei Suchmaschinen.“

Doch warum verhält sich Wikipedia so, fragen sich die meisten REL-NOFOLLOW-Gegner, die seit längerem die Vorgehensweise von Wikipedia kritisieren. Der Grund steckt in der Suchmaschinenoptimierung, also SEO: Wikipedia möchte um jeden Preis mit seinen Inhalten sehr weit oben in den Suchtreffern stehen. Die externen Websites dagegen, von deren Wissen Wikipedia im Grunde profitiert, dürfen sich allerhöchstens auf eine Erwähnung innerhalb des Artikels freuen, mehr aber nicht. Keinesfalls sollen sie von den Suchmaschinen besser bewertet werden als der eigentliche Wikipedia-Artikel.

Daneben besteht ein weiterer wichtigster Grund für Wikipedia, eine solche REL-NOFOLLOW-Funktion zu nutzen: Je mehr Links auf eine Website verweisen, desto höher rutscht sie in den Suchergebnissen einer Suchmaschine. Wenn dagegen mehr Links von einer Website rausgehen, wird die Website wieder in den Suchtreffern herabgestuft. Aus diesem Grund hat sich Wikipedia dazu entschlossen, auf gar keine Website zu verlinken. Denn aus Sicht der Suchmaschinen hat Wikipedia keine Links, wenn das kritische REL-NOFOLLOW-Attribut genutzt wird. Auf diese Weise verlinken Menschen zwar auf Wikipedia, Wikipedia dagegen verlinkt nicht zurück – es gibt quasi keine Backlinks von Wikipedia. Die Inhalte von Wikipedia erscheinen bei Suchtreffern also stets ganz weit oben.

Andererseits verpflichtet die Wikipedia-Lizenz jede Quelle, auch auf die Enzyklopädie zu verlinken, sobald auch nur ein Satz von einem Wikipedia-Artikel zitiert wird. Genau aus diesem Grund nutzt Wikipedia nicht die sonst so frei gehandhabte GNU-Lizenz, die ursprünglich vom Vater des Open Source Richard Stallman gemäß einer informationsfreiheitlichen Ethik erschaffen wurde: „Informationen müssen frei sein.“ Stattdessen müssen sich Nutzer der Inhalte an mehrere Bedingungen einhalten, darunter an die von Wikipedia selbst verfassten „Terms of Use“. Kurzum: Wer also zu Wikipedia verlinkt, schenkt Wikipedia eine weitere Verlinkung und somit höheres Ranking bei Google. Wird man selbst von Wikipedia verlinkt, hat dies für die Suchmaschine keine Auswirkung.